|

|

|

|

|

|

|

|

【愈來愈多人用人功智能診斷健康】滑鐵盧大學研究稱當中存在風險

(2025/5/31)

【明報專訊】一項滑鐵盧大學最新研究警告,用人功智能診斷健康問題存在風險。

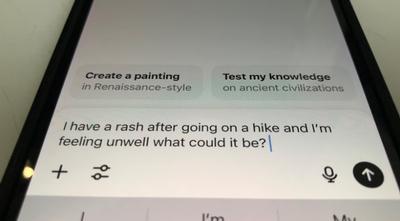

隨著加拿大人越來越多用人功智能來快速解答健康問題,一項新研究警告說,依賴像 ChatGPT這樣的人工智能工具進行自我診斷可能存在風險。

由滑鐵盧大學研究人員領導的一個團隊,評估了OpenAI發布的大型語言模型 (LLM) ChatGPT-4 的表現。

該聊天機器人被問及一系列開放式醫學問題,這些問題改編自醫學執照考試中的情境。

研究結果令人震驚,只有31%的ChatGPT回答被認為完全正確,而只有34%被認為清晰。

領導該研究團隊的滑鐵盧大學博士生扎達(Troy Zada)說:「所以,這個比例不是很高」。

他又說:「如果它告訴你這是正確答案,即使它是錯的,那也是一個大問題,對吧?」

研究人員將ChatGPT-4與其早期版本 3.5 進行了比較,發現有顯著改進,但仍不足夠。

在一個案例中,聊天機器人自信地診斷出患者的皮疹是對洗衣粉的過敏反應。但事實上,這是由乳膠手套引起的這個關鍵細節被AI忽略了,儘管它被告知患者學習與停屍間有關的學問,並使用手套。

研究人員得出結論,大型語言模型尚未足夠可靠,無法取代醫療專業人員,在處理健康問題時應謹慎使用。儘管有研究發現AI聊天機器人在某些情況下可以勝過人類醫生,並通過涉及多項選擇題的醫學考試。

扎達表示,他並不是建議人們停止使用ChatGPT獲取醫療資訊,但他們必須意識到其局限性和潛在的錯誤資訊。

札達又說:「它可能會告訴你一切都很好,但實際上存在一個嚴重的潛在問題。」

他說,它也可能提供一些資訊,讓人們不必要地擔心。

目前數百萬加拿大人沒有家庭醫生,人們擔心有些人可能會依賴人功智能來診斷健康問題,儘管AI聊天機器人通常會建議用戶諮詢真正的醫生。

研究人員還指出,聊天機器人缺乏問責制,而人類醫生則可能因錯誤而面臨嚴重後果,例如執照被吊銷或被控醫療事故。

雖然研究人員指出,ChatGPT的回答沒有出現任何嚴重的錯誤,但他們提供了一些簡單的建議。

札達說:「當你得到一個回答時,一定要驗證該回答。」

基爾帕拉尼(Amrit Kirpalani)醫生也同意這一點。他是一名兒科腎臟病學家和安省西安大學的助理教授,曾研究醫學中的人功智能,並注意到越來越多的患者及其家人提及 ChatGPT等人功智能平台。

他認為醫生應該主動與患者討論其使用情況,因為有些人可能不願談論。

基爾帕拉尼說:「沒有人願意告訴他的醫生,他們在ChatGPT上查詢了,而它告訴他們不同的東西。」

他更希望患者與醫生討論聊天機器人的回答,特別是因為人功智能有時甚至比人類更有說服力。

他說:「我不確定我是否能像人功智能工具那樣有說服力。它們可以以更簡單、更易懂的方式解釋一些事情。但準確性並不總是存在。所以它即使是錯的,也可能非常有說服力。」

他將人功智能比作另一個熟悉的線上工具。

他表示,有點像用維基百科的比喻,它可能是一個很好的資訊來源,但不應該是個人主要來源。它可以是一個起點。

研究人員也承認,隨著大型語言模型的持續改進,它們最終可能在醫療環境中被可靠地使用。但就目前而言,

面對人功智能,札達說:「不要盲目去接受結果。」

|

|

|

|

|

|

|

|

| A D V E R T I S E M E N T |

|

| |

| |

| |

|

|

| |

| A D V E R T I S E M E N T |

|

| |

| |

| |

|

|

|

| |

|

|

|

| [] [] [] [] [] [] |

|

|

|

| MING PAO DAILY NEWS |

| A wholly owned subsidary of Ming Pao Enterprise Corporation Ltd. |

|

|

1355 Huntingwood Drive, Scarborough, Ontario, Canada M1S 3J1

Tel.: (416) 321-0088 Fax: (416) 321-9663 Advertising Hotline Tel: (416) 673-8250

|

|

|

|